(Слева)

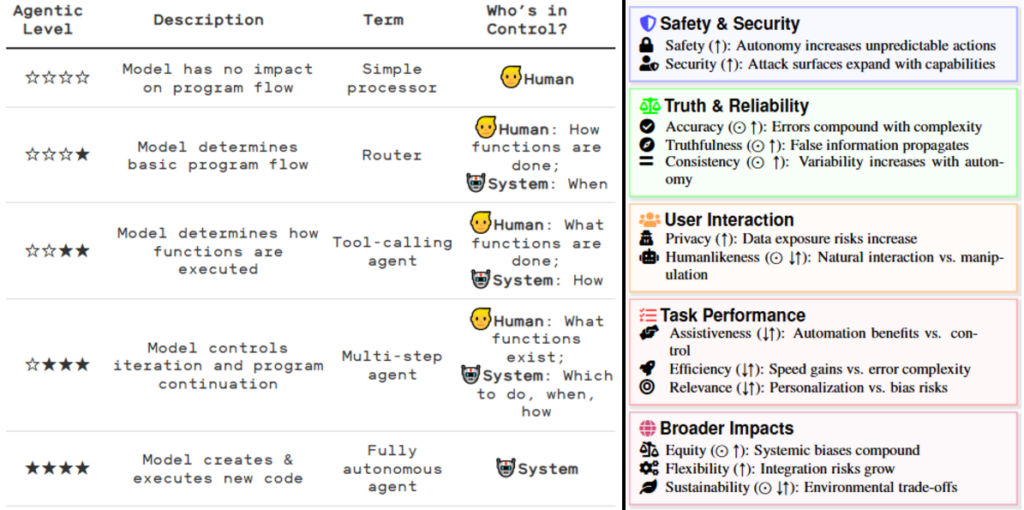

Уровни ИИ-агента: Системы, использующие модели машинного обучения, могут иметь различные уровни агентности. Они также могут быть объединены в «мультиагентные системы», где один рабочий процесс агента запускает другой, или несколько агентов совместно работают над достижением цели.

(Справа)

Анализ выгод и рисков

⭡: риск увеличивается с автономией

⇅: компенсация риска-выгоды

☉: базовая модель распространяет текущий риск

I. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

II. Робот должен повиноваться всем приказам, которые отдает человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

III. Робот должен заботиться о своей безопасности в той мере, в какой это не противоречит Первому и Второму Законам.

Руководство по роботехнике, 56-е издание, 2058 г.

– Айзек Азимов

«Я, робот» (1950)

«Концепция «агентности» (agency) занимает центральное место в дискуссиях об автономных системах ИИ, однако его значение и последствия остаются философски спорными. В общем смысле, агент понимается как субъект, обладающий способностью действовать. Применение этой концепции к искусственным системам поднимает вопросы о природе интенциональности (намеренности) этих действий: в философской литературе агентность обычно понимается через призму намеренного действия, где действия объясняются с точки зрения ментальных состояний агента (например, убеждений, желаний) и его способности действовать по причинам, но искусственные интеллектуальные агенты, как известно, не обладают ментальными состояниями в историческом понимании. Это позволяет предположить, что агентам ИИ не хватает фундаментальных характеристик подлинной агентности. Таким образом, философские основы, поддерживающие развитие «агентности» у ИИ-агентов и вообще, можно ли сказать, что агенты ИИ обладают «агентностью» — остаётся под вопросом.

Риски автономного агентного ИИ:

‣ Неточности системы и несогласованность

‣ Нарушения конфиденциальности (privacy), безопасности (safety)

и защищенности (security)

‣ Распространение ложной информации

‣ Потеря контроля за пределами установленных человеком ограждений (guardrails)

Fully Autonomous AI Agents Should Not be Developed ⛛

Почему так важно оставить «человека в петле» (human-in-the-loop) (не висеть, а замыкать на себя логическую цепочку)?

[…]«Как он мне рассказывал, Бжезинского разбудил в три часа ночи [военный помощник Уильям] Одом, который сообщил ему, что по Соединенным Штатам было запущено около 250 советских ракет. Бжезинский знал, что время принятия президентом решения об ответном ударе составляет от трёх до семи минут. Поэтому он сказал Одому, что будет ждать дополнительного звонка, чтобы подтвердить запуск советских ракет и предполагаемые цели, прежде чем звонить Президенту. Бжезинский был убежден, что мы должны нанести ответный удар, и сказал Одому подтвердить, что Стратегическое воздушное командование запускает свои самолеты. Когда Одом перезвонил, он сообщил, что запущено 2 200 ракет (?) Это была тотальная атака. За минуту до того, как Бжезинский собирался позвонить Президенту, Одом позвонил в третий раз и сказал, что другие системы предупреждения не сообщают о советских пусках. Сидя один посреди ночи, Бжезинский не стал будить жену, полагая, что через полчаса все будут мертвы. Это была ложная тревога. Кто-то по ошибке ввёл в компьютерную систему кассеты с записями военных учений».

– Robert M. Gates.

«From the Shadows: The Ultimate Insider’s Story of Five Presidents and How they Won the Cold War»

Человеческие институты пока не в состоянии справиться с отлетевшими пидорами у власти, какой нахуй автономный ИИ?

По теме:

- Максимизатор скрепок и капитала

Пифос Пандоры:

·︎ Автоматоны, големы, роботы (Часть 1)

·︎ Хамовитый чатбот Microsoft, стохастические попугаи и Батлерианский джихад (Часть 2) - The Great Automatic Grammatizator (https://t.me/neuroexistencialism/2828)